Καθώς ο τεχνολογικός τομέας «τρέχει» να αναπτύξει πανίσχυρα chatbots τεχνητής νοημοσύνης, η ευρύτατη υιοθέτησή τους έχει πυροδοτήσει ανησυχίες για την προστασία των προσωπικών δεδομένων στις ρυθμιστικές αρχές, αλλά και τους ίδιους τους παράγοντες της αγοράς.

Ορισμένες εταιρείες, μεταξύ των οποίων η JPMorgan Chase, έχουν σπεύσει να μπλοκάρουν τη χρήση του ChatGPT , του πιο δημοφιλούς ίσως chatbot, εξαιτίας ανησυχιών για τη χρήση λογισμικού τρίτων μερών από τους υπαλλήλους. Όταν μάλιστα η OpenAI, η εταιρεία πίσω από το ChatGPT, αποκάλυψε ότι χρειάστηκε να βγάλει προσωρινά offline το chatbot στις 20 Μαρτίου, προκειμένου να διορθώσει ένα bug, που επέτρεπε σε ορισμένους χρήστες να δουν ένα μέρος της ιστορίας συνομιλιών άλλων χρηστών.

Το ίδιο bug, που τώρα διορθώθηκε, επίσης έδινε τη δυνατότητα «ορισμένοι χρήστες να δουν το μικρό όνομα και το επίθετο, τη διεύθυνση ηλεκτρονικού ταχυδρομείου, τη διεύθυνση αποστολής της απόδειξης πληρωμής, τα τελευταία 4 ψηφία της πιστωτικής κάρτας και την ημερομηνία λήξης της» όπως έγραψε σε blog η OpenAI. Και μόλις την περασμένη εβδομάδα οι ρυθμιστικές αρχές της Ιταλίας εξέδωσαν προσωρινή απαγόρευση του ChatGPT στη χώρα, επικαλούμενοι ανησυχίες για την ιδιωτικότητα.

Ένα μαύρο κουτί δεδομένων

«Οι ανησυχίες για τα προσωπικά δεδομένα δεν είναι μία υπερβολή» λέει στο CNN ο Μαρκ Μακρίρι, συνπρόεδρος της εταιρείας Fox Rothschild. «Είναι σαν ένα μαύρο κουτί». Με το ChatGPT να έχει λανσαριστεί στο κοινό στα τέλη Νοεμβρίου, οι χρήστες μπορούν να παράξουν εργασίες για το σχολείο και το πανεπιστήμιο, ποιήματα, στίχους τραγουδιών, μικρές ιστορίες κτλ, δίνοντας απλώς οδηγίες.

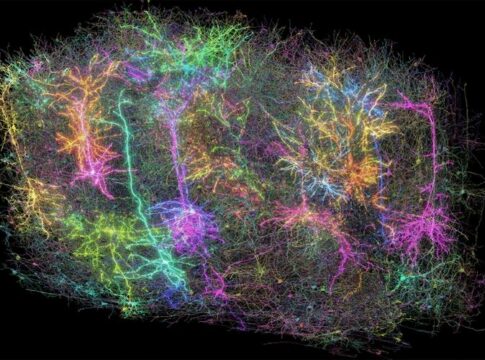

Οι Google και Microsoft έχουν έκτοτε λανσάρει τα δικά τους εργαλεία τεχνητής νοημοσύνης, τα οποία λειτουργούν με παρόμοιο τρόπο και στηρίζονται από γλωσσικά μοντέλα, που έχουν εκπαιδευτεί με τεράστιες ποσότητες online δεδομένων. Όταν οι χρήστες καταγράφουν πληροφορίες σε αυτά τα εργαλεία δεν μπορούν να γνωρίζουν το πώς θα χρησιμοποιηθούν αυτές, εξηγεί ο Μακρίρι. Αυτό εγείρει σημαντικούς φόβους στις επιχειρήσεις. Και καθώς ολοένα και περισσότεροι υπάλληλοι υιοθετούν τα εργαλεία αυτά για να τους βοηθήσουν με τα email, που πρέπει να στείλουν ή τις σημειώσεις από τις συσκέψεις, δημιουργείται ένα παράθυρο ευκαιρίας για όσους θα ήθελαν να κλέψουν εταιρικά μυστικά.

Ο Στιβ Μιλς, επικεφαλής ζητημάτων ηθικής που συνδέονται με την τεχνητή νοημοσύνη, στην Boston Consulting Group, είπε στο CNN ότι η μεγαλύτερη ανησυχία για την ιδιωτικότητα στις επιχειρήσεις αφορά την ακούσια αποκάλυψη ευαίσθητων πληροφοριών.

Πολιτική ιδιωτικότητας των 2.000 λέξεων

H OpenAI αναφέρει ότι μπορεί να χρησιμοποιήσει τις πληροφορίες για να βελτιώσει ή να αναλύσει τις υπηρεσίες, να διενεργήσει έρευνα, να επικοινωνήσει με χρήστες και να αναπτύξει νέα προγράμματα και υπηρεσίες, μεταξύ άλλων. Η πολιτική της για την προστασία της ιδιωτικότητας εξηγεί επίσης ότι μπορεί να προσφέρει προσωπικές πληροφορίες σε τρίτα μέρη, χωρίς προηγούμενη ειδοποίηση προς τους χρήστες, εκτός και εάν αυτό απαιτείται από τον νόμο. Η πολιτική προστασίας της ιδιωτικότητας της εταιρείας ορίζεται μέσα σε 2.000 λέξεις και είναι ελαφρώς «θολή», κάτι που συναντά κανείς συχνά στην εποχή του Διαδικτύου. Παράλληλα έχει ξεχωριστό έγγραφο με Όρους Χρήσης, το οποίο ουσιαστικά επιρρίπτει το μεγάλο μέρος της ευθύνης στον ίδιο τον χρήστη να λάβει τα κατάλληλα μέτρα και τη χρήση του εργαλείου.

naftemporiki.gr